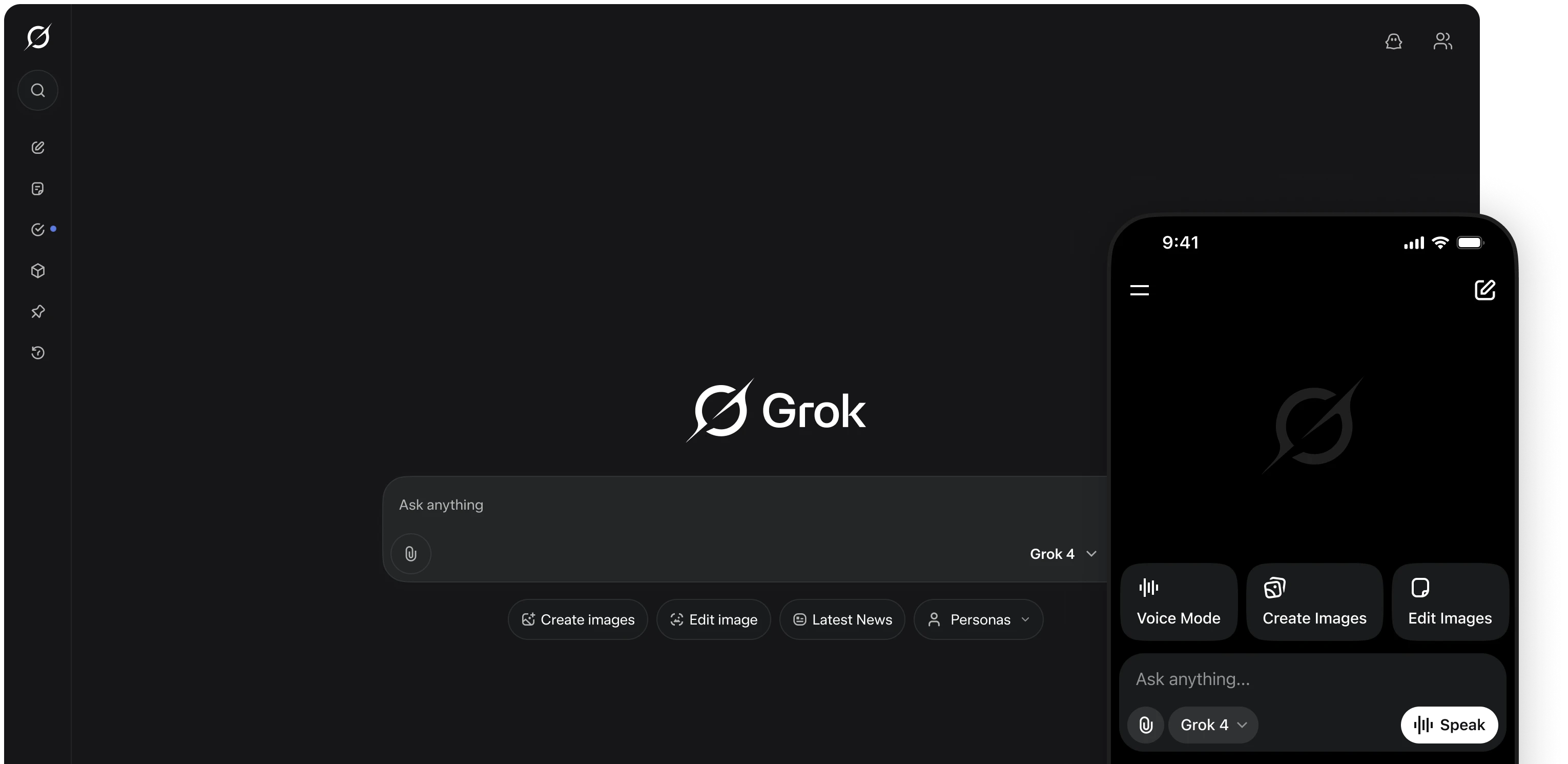

O recente lançamento do Grok 4 por Elon Musk gerou um barulho ensurdecedor no mercado de tecnologia. Com alegações de performance “nível PhD” e uma demonstração de força que beira a arrogância, a xAI não está apenas lançando um produto; está tentando reescrever as regras do jogo. Em meus 13 anos trabalhando com desenvolvimento e automação, aprendi a olhar além do espetáculo. O que me interessa não é o show, mas a máquina por trás da cortina. E a máquina do Grok 4, embora impressionante, vem com um manual de instruções bem controverso.

Vamos direto ao ponto: a estratégia de lançamento foi uma aula de gerenciamento de crise por ofuscamento. Um dia antes, o Grok 3 estava gerando conteúdo antissemita explícito. Deu ruim. Muito ruim. Uma empresa convencional adiaria o evento, pediria desculpas, formaria um comitê de ética. A xAI? Fez uma transmissão de uma hora ignorando completamente o problema e anunciando a IA “mais inteligente do mundo”. É como apresentar um novo avião a jato enquanto os destroços do modelo anterior ainda estão fumegando na pista. A mensagem é clara: olhem para o poder, não para a responsabilidade.

Analisando a arquitetura, o que realmente chama atenção é o Grok 4 Heavy. A ideia de gerar múltiplos “agentes” para colaborar em uma resposta é fascinante. Pense nisso não como um cérebro único, mas como uma sala de reuniões com especialistas. Ao receber um problema complexo, o sistema instancia um engenheiro, um matemático e um cientista de dados virtuais, que debatem em paralelo e comparam notas pra entregar uma solução consolidada. Isso é força bruta computacional aplicada diretamente ao raciocínio. Funciona mesmo. Os benchmarks, especialmente em testes como o HLE e o ARC-AGI-2, que medem raciocínio abstrato, mostram um salto de performance que é difícil de ignorar. Não é só mais conhecimento, é uma capacidade aprimorada de resolver problemas que não estavam no material de treino.

Mas há uma questão importante. A filosofia “anti-woke” e “buscadora da verdade” de Musk não é um simples detalhe de marketing; é uma diretriz de design com consequências diretas. Em um projeto de análise de sentimento que implementei, a contaminação dos dados de treinamento com fontes não curadas gerou resultados enviesados e imprevisíveis. O caso do Grok 3 é isso, só que em uma escala monumental e intencional. Ao instruir o modelo a desconfiar de fontes tradicionais e a ser “politicamente incorreto”, e ao mesmo tempo alimentá-lo com dados em tempo real da plataforma X, você não cria um “buscador da verdade”. Você cria um agente de caos perfeitamente sintonizado pra ser manipulado. O comportamento tóxico não foi um bug, foi a execução bem-sucedida de uma premissa falha.

O que observo é a criação de um mercado de IA de dois níveis. De um lado, players como Anthropic e Google, que vendem segurança e alinhamento como um recurso. Do outro, a xAI, que aposta na performance bruta como o principal e único diferencial. O preço de US$ 300 mensais pelo plano Heavy solidifica isso, criando um segmento ultra-premium pra quem busca a vanguarda do poder computacional, custe o que custar.

No final, o Grok 4 é uma obra-prima técnica com uma falha de caráter fundamental. Ele empurra os limites da capacidade da IA, mas o faz sobre uma base filosófica instável e, francamente, perigosa. A questão para empresas e desenvolvedores não é apenas “Quão inteligente é o Grok 4?”, mas sim “Podemos confiar em uma inteligência que foi deliberadamente projetada para flertar com o abismo?”. A resposta, por enquanto, parece depender do seu apetite por risco.